Вряд ли искусственный интеллект как таковой «виноват» в каких-либо своих «поступках» и их последствиях. Однако ИИ может привести к событиям, связанным с посягательством на собственность других субъектов. Какая в этом случае ответственность за действия искусственного интеллекта?

ИИ может стать причиной правонарушений:

- аварий по вине беспилотного автомобиля;

- разбитого дроном оконного стекла, управляемым ИИ;

- травм, нанесённых на заводе роботом с искусственным интеллектом;

- разрушения содержимого интеллектуальной холодильной камеры из-за ошибки автоматического выбора температуры;

- направления пристава не тому человеку системой ИИ и др.

Фундаментальный вопрос, на который необходимо ответить, заключается в следующем:

Что является основанием ответственности за подобные правонарушения и кто должен нести эту ответственность? Как юридически следует классифицировать правонарушения, связанные с функционированием искусственного интеллекта?

Вопреки видимости, этот вопрос не слишком нов. Есть много вариантов ответов на него. Юридическая дискуссия на эту тему ведётся уже как минимум несколько лет. Они становятся всё более важными, например, для ведения бизнеса.

Рассмотрим конкретные случаи ответственности за действия искусственного интеллекта.

- Ущерб, причинённый ИИ и человеком, который его использует

- «Разрыв ответственности»

- Ответственность за действия искусственного интеллекта: выбор политики и законов

- Ответственность владельца автономного транспортного средства

- Кто виноват?

- Ответственность за AI по аналогии с домашними животными

- «Надзор» за ИИ

- Производство, приведённое в движение природной энергией

- Ответственность за действия искусственного интеллекта: принцип договорной ответственности

- Санкции за ИИ

- Ответственность за опасную продукцию

- Ответственность за действия искусственного интеллекта: как действует режим опасной продукции?

- Правовая ответственность за действия искусственного интеллекта: каким должен быть наш подход?

Ущерб, причинённый ИИ и человеком, который его использует

Есть потенциальный вред, который может быть причинён использованием искусственного интеллекта. Также разнообразны причины этого вреда. Следует помнить, что ИИ может представлять собой:

- «чисто программный» инструмент для работы с данными;

- оператора автономных транспортных средств и машин (автомобилей, дронов, роботов и т. д.).

Ущерб может быть:

- материальным;

- нематериальным (вред человеку);

- причинённым человеком с использованием искусственного интеллекта (ИИ как инструмента);

- причинённым человеком «автономно», без непосредственного участия ИИ.

Правонарушения, причинённые людьми, такие как хакерская атака с использованием искусственного интеллекта, не представляют большой проблемы с точки зрения анализа ответственности за правонарушения. Их можно квалифицировать как традиционные правонарушения, совершённые с использованием определённого инструмента. Однако глобальная проблема возникает, когда искусственный интеллект «самостоятельно» – без ведома и воли человека – вызывает фактическое событие, которое приводит к нанесению ущерба данному объекту.

«Разрыв ответственности»

Существует понятие «разрыв ответственности». Оно означает ситуацию, при которой существует правовой пробел, касающийся возможности возложения ответственности. Может ли такая ситуация существовать в правовой системе?

Во-первых, на первый взгляд существует так много субъектов, на которые потенциально можно возложить ответственность, что сложно определить правильного «виновного»:

- разработчика алгоритма;

- производителя продукта;

- субъекта, реализующего или обучающего модель ИИ;

- конечного пользователя и др.

Во-вторых, помните, что реальность всегда на шаг опережает закон. Поэтому в законе неизбежно должны появиться лазейки. В подобных случаях гражданское право уже много лет пользуется своим главным оружием – аналогией. Аналогия является абсолютно базовой, обычной процедурой в гражданском праве и неоспоримым полезным принципом. По этой причине, даже если бы мы имели дело с чем-то вроде «разрыва ответственности», этот пробел можно (и нужно) заполнить с помощью аналогии. Система гражданского права не выдержит вакуума.

Ответственность за действия искусственного интеллекта: выбор политики и законов

Ключевым вопросом в контексте гражданско-правовой ответственности за ИИ является выбор принципа этой ответственности:

- вины (часто рассматриваемого в гражданском праве как неисполнение, связанного с наибольшими трудностями в доказательствах для потерпевшего);

- вины за надзор;

- риска (гораздо более благоприятного для потерпевшей стороны);

- справедливости;

- гарантии (в более широком смысле он присутствует только в договорах страхования).

Для так простого искусственного интеллекта нет препятствий для применения принципа вины. Простой (или «слабый») ИИ не предназначен для выполнения однотипных задач относительно невысокого уровня сложности, если он действительно является лишь инструментом в руках человека (т.е. его уровень автономности низкий). Использование искусственного интеллекта в этом случае ничем не отличается, например, от намеренного натравливания собаки на прохожего (если хозяин подаст собаке команду на атаку) или использования лома для взлома.

Проблема возникает в ситуации, когда человек не контролирует искусственный интеллект, т.е. уровень автономности ИИ высок. Тогда возникает ощущение, что принцип вины может быть неадекватным. Оператор или производитель ИИ не должен иметь возможности «умыть руки», потому что искусственный интеллект повёл себя не так, как ожидалось.

На практике предприниматель будет нести обязательства за все последствия работы ИИ, если только они не вызваны обстоятельствами, не связанными с ИИ. Например, когда:

- кто-то прыгает под колёса беспилотного автомобиля;

- ошибка ИИ возникает по вине хакера, от нападения которого невозможно было защититься и др.

Потребитель будет нести ответственность за ущерб, причинённый искусственным интеллектом, если он использовал его неправильно («не в соответствии с инструкциями»). Это интересная концепция, но всего лишь концепция. Пока никаких законодательных оснований нет. Ответственность за действия искусственного интеллекта будет ещё трансформироваться в этом аспекте.

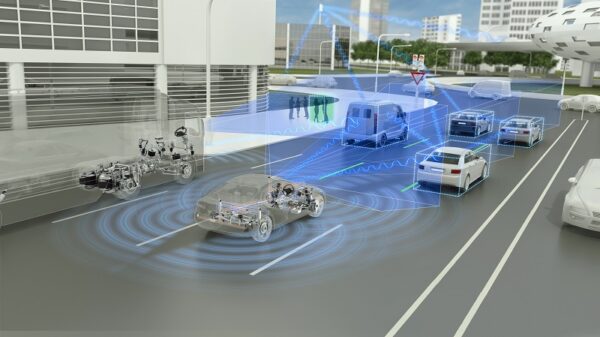

Ответственность владельца автономного транспортного средства

Существует ответственность владельца механического транспортного средства. У автономного транспортного средства есть все функции традиционного ТС. Также у него есть дополнительная функция управления с помощью программного обеспечения.

Вопрос ответственности за беспилотное транспортное средство остаётся вопросом ответственного лица. Должен ли быть ответственным создатель программного обеспечения, производитель автомобиля или, возможно, его пользователь?

Ответственность всё равно лежит на пользователе (водителе) – лице, осуществляющим фактическое управление автомобилем, а не только на его владельце. Такая ответственность основана на принципе риска. Ответственность исключается только обстоятельствами непреодолимой силы или исключительной виной потерпевшего или третьего лица). Это обосновано аспектом значительной опасности, связанной с использованием такого транспортного средства.

Похоже, в будущем использование автомобилей, управляемых ИИ, может вызывать меньшую опасность на дорогах, чем вождение человека.

Суть беспилотных автомобилей заключается в том, что роль «оператора», помимо определения пункта назначения поездки, фактически сводится к роли пассивного пассажира. Так почему же он должен нести риск ответственности за ошибку в программном обеспечении, управляющем автомобилем или его датчиками?

Здесь представляется необходимым законодательное вмешательство. Оно возлагает ответственность за инциденты с участием беспилотных автомобилей на их производителей или дистрибьюторов. Дискуссия на эту тему осложняется тем фактом, что несомненное будущее доминирование беспилотных автомобилей на городских улицах может глубоко изменить модель владения автомобилями.

В качестве создателей или покупателей и субъектов, контролирующих модели ИИ, управляющие автомобилями (и в некоторой степени ответственных за физические датчики, установленные в автомобиле), производители или дистрибьюторы – наиболее подходящие субъекты, на которых лежат обязательства.

Кто виноват?

Рассматриваемые обязательства не являются абсолютными и подлежат ограничениям. К ним относятся ситуации, когда ущерб причинён:

- обстоятельствами непреодолимой силы;

- по исключительной вине потерпевшей стороны;

- исключительно по вине третьего лица, за которую владелец ответственности не несёт.

Что сразу обращает на себя внимание, так это исключительная вина третьего лица. Кажется, что вина абсолютна. К сожалению, шансы доказать, что ущерб возник исключительно по вине одного из этих двух субъектов, невелики.

Здесь явно видна необходимость изменить законы, прежде чем разрешить беспилотные транспортные средства для общего использования. Кстати, это важно для системы обязательного страхования. Положения законов об обязательном страховании устанавливают размер возмещения в «пределах гражданской ответственности» владельца или водителя транспортного средства.

Кроме того, неясно, как это будет распространяться на дроны, то есть на объекты, движущиеся в воздухе, используемые для:

- развлечения;

- фотосъёмки;

- видеосъёмки;

- для перевозки посылок.

По нашему мнению, дроны, управляемые ИИ, должны регулироваться с точки зрения ответственности так же, как и беспилотные автомобили.

Ответственность за AI по аналогии с домашними животными

Не очень очевидна, но заслуживает внимания возможность применения тех же статей законов, которые устанавливают ответственность за животное. Сравнение ИИ с животным вызывает определённый внутренний конфликт, поскольку оно кажется одновременно адекватным и неточным:

- с одной стороны, искусственный интеллект – это нематериальное, искусственное творение, созданное человеком, результат сложного программирования и математической работы.

- с другой стороны, животное является живым существом с ограниченным по сравнению с человеком уровнем сознания и интеллекта.

При «покупке» ИИ, который компании будут использовать для обслуживания клиентов, они должны использовать соответствующие контрактные механизмы. Эти механизмы, если потребитель сообщит об ущербе, позволят компаниям «переложить» понесённые расходы на поставщика (так называемый регресс) или привлечь его к активной защите от претензий третьих лиц.

В то же время и искусственный интеллект (на его нынешнем уровне развития), и животные имеют определённые общие черты, которые могут стать юридически значимыми. Прежде всего, и искусственный интеллект, и животные характеризуются хоть какой-то степенью автономности. Они способны учиться, приобретать новые навыки и действовать самостоятельно. Однако об их осознанности (в полном смысле) или намерении говорить нельзя. Люди имеют на них огромное влияние, но они не могут определить или предсказать каждое их поведение.

«Надзор» за ИИ

Животные и модели ИИ остаются под контролем человека, что само по себе предполагает термин «надзор». По этим причинам ни животному, ни искусственному интеллекту в настоящее время нельзя приписать что-то вроде вины за какое-либо из его действий. Но эту вину, в свою очередь, можно возложить на контролирующего человека. Может ли ответственность за поведение ИИ основываться на тех же положениях закона, что и ответственность за домашних животных?

Кто держит или использует животное, обязан возместить причинённый им ущерб. Это не зависит от того, находилось ли животное под присмотром, заблудилось или сбежало (за исключением случаев, когда ни он сам, ни лицо, ради которого оно несёт ответственность, не виноваты). Даже если лицо, использующее животное, не несёт ответственности, то потерпевшая сторона может потребовать от него полного или частичного возмещения ущерба.

Применительно к ИИ это означает, что оператор ИИ несёт ответственность за свои действия, если только, несмотря на тщательное следование инструкциям, ИИ не выйдет из-под контроля. Законодательство может прямо предусмотреть аналогичный механизм для ИИ.

Производство, приведённое в движение природной энергией

Иногда предлагается ответственность:

- для администратора ИИ, не являющегося предпринимателем, на основании вины;

- для администратора ИИ, являющегося предпринимателем, на основании риска.

Это интересная концепция, но всего лишь концепция.

Строгую ответственность несёт каждое лицо, управляющее за свой счёт предприятием или установкой, приведёнными в движение природной энергией:

- паром;

- газом;

- электричеством;

- жидким топливом и др.

Предполагается, что это «приведение в движение природной энергией» означает, что предприятие непосредственно использует энергию природы в рамках процессов преобразования природных форм энергии. Это делается с помощью машин или других устройств, установленных в движение в целом этими природными ресурсами. Функционирование предприятия зависит от использования этих природных энергий.

Таким образом, представляется, что компании, которые используют роботов или машины, контролируемые в некоторой степени искусственным интеллектом, будут подпадать под регулирование будущих законов об искусственном интеллекте.

Это коснётся электростанций, шахт, заводов, автоматизированных складов и аэропортов. В этих примерах реализуется предпосылка «преобразования» энергии с целью «приведения в движение» предприятия – и, следовательно, его функционирования благодаря «работе» роботов или машин.

Стоит отметить, что вопрос управления ИИ здесь неактуален (важен источник энергии для предприятия).

Как обстоит дело с предприятием, важной движущей частью которого является программное обеспечение? Или предприятием, чья деятельность ограничивается исключительно виртуальной областью (например, виртуальная электростанция, управляемая искусственным интеллектом)? Принцип риска в отношении движения такого предприятия будет означать следующее. Администратор этого предприятия будет нести ответственность за любой ущерб, причинённый третьему лицу. Он ответственен за ущерб даже в том случае, если он ранее не нёс никаких обязательств (например, когда произошло что-то непредвиденное, несмотря на то, что он осуществлял добросовестный надзор за предприятием).

Пределом ответственности здесь будут форс-мажорные обстоятельства или исключительная вина потерпевшей стороны или третьего лица, находящегося вне ответственности администратора компании (т.е. ущерб, причинённый, например, нарушением работником очевидных стандартов безопасности, освобождается от ответственности).

На наш взгляд, в сфере требований закона было бы желательно создать аналогичный механизм.

Ответственность за действия искусственного интеллекта: принцип договорной ответственности

Договорная ответственность (за неисполнение или ненадлежащее исполнение контракта) не требует особых изменений, вызванных развитием ИИ.

Этот вид обязательств основан на принципе свободы сторон:

Если Вы можете договориться о том, что будет сделано, Вы лучше договоритесь о последствиях, что будет, если не сделать того, что предполагалось.

Он основан на договорах и имеет определённые ограничения.

На рынке ИТ уже много лет существует набор стандартов, которые повторяются практически в каждом контракте. К ним относятся:

- исключение ответственности за упущенную выгоду (например, если транзакционная система банка «сломается» по вине поставщика ИТ, тогда поставщик несёт ответственность в пределах стоимости ремонта «сломанных» элементов, но не несёт ответственности за стоимость банковских транзакций, которые банк совершил бы, если бы система не вышла из строя);

- ограничение общей ответственности за ущерб стоимостью контракта (например, 100% вознаграждения за внедрение и лицензирование системы);

- исключения из этого ограничения обязательства, которые в настоящее время чаще всего охватывают (кроме умышленной вины, вытекающей из правил: грубая небрежность, ущерб, причинённый наличием юридического дефекта продукта, раскрытие конфиденциальной информации, нарушение персональных данных, нарушение важных принципов кибербезопасности);

- исключение гарантии на физические дефекты.

Ожидается, что этот стандарт будет сохранён и для контрактов ИИ. Изменения, которые произойдут в законе об ИИ, могут включать расширение списка исключений из лимита ответственности.

Санкции за ИИ

Санкции, вытекающие из контракта, должны быть соответствующим образом агрегированы с должным образом описанными требованиями к модели ИИ, включая параметры качества в контракте. Эти требования и параметры не могут быть простой копией положений существующих ИТ-контрактов (но в новой формулировке ИИ). Необходимо адаптировать их к целям, связанным с искусственным интеллектом.

Независимо от того, кто в настоящее время или в будущем будет нести ответственность за ущерб, причинённый конкретными системами или моделями ИИ, сегодня, заключая контракты на их поставку, обучение, разработку и обслуживание, нужно проявить фантазию и защитить себя соответствующим образом.

Субъекты, которые несут (или могут нести) ответственность как производители или дистрибьюторы продуктов (или услуг ИИ) – это не обязательно классические поставщики. Это могут быть:

- транспортные компании, предоставляющие автономные такси;

- банки, использующие ИИ;

- медицинские учреждения, использующие ИИ для диагностики;

- заводы, использующие искусственный интеллект, управляющий промышленными роботами и т. д.

При «покупке» ИИ, который будет использоваться для обслуживания клиентов, компании должны использовать соответствующие контрактные механизмы. Если потребитель сообщит об ущербе, эти контрактные механизмы позволят компаниям «переложить» понесённые расходы на поставщика или привлечь его к активной защите от претензий третьих лиц.

Ответственность за опасную продукцию

Рассматривая возможность применения положений об опасной продукции к искусственному интеллекту, мы сталкиваемся с фундаментальной проблемой. Дело в том, что под товаром понимается движимая вещь, даже если она соединена с другой вещью (животные и электричество также считаются продуктами).

Можно ли применить к искусственному интеллекту положения, касающиеся вещей, а значит и материальных объектов по смыслу Гражданского кодекса? Для самой модели ИИ и программного обеспечения, ответ отрицательный. Постановления об опасных продуктах должны распространяться на вещи – материальные объекты, а не на программное обеспечение.

Однако нет никаких препятствий для включения ИИ в режим ответственности за качество продукции, если он является элементом материального объекта, то есть программным обеспечением, которое управляет предметом (например, роботом). Предпосылка, определяющая допустимость такой квалификации, заключается в том, что искусственный интеллект «заякорен» в материальном мире и «связан» с вещью. Однако «чистое» программное обеспечение не может быть включено в такой режим.

Ответственность за действия искусственного интеллекта: как действует режим опасной продукции?

Продукция может быть опасной – т.е. не обеспечивать безопасность, которую можно было бы ожидать с учётом нормального использования продукции. Она может сработать неожиданно. Например, если телефон перегреется и станет причиной ожогов, если кухонный комбайн взорвётся и т.п. В этом случае производитель продукции (и в некоторой степени также дистрибьютор или импортёр) несёт ответственность за ущерб, причинённый опасным продуктом.

Это кажется интересным легальным вариантом для использования ИИ (в роботах, дронах и других транспортных средствах, бытовой технике, игрушках, датчиках и других устройствах).

Следует помнить, что ответственность за опасный продукт подлежит многочисленным ограничениям, в том числе, когда:

- опасные свойства продукта стали очевидными после его размещения на рынке, если только они не возникли по причине, ранее присущей продукту;

- опасные свойства продукта невозможно было предсказать с учётом состояния науки и техники на момент размещения продукта на рынке (или когда эти свойства возникли в результате применения положений законодательства);

- в отношении предметов, уничтоженных опасным товаром, – когда они не использовались преимущественно для личного пользования (т.е. режим защиты от имущественного ущерба действительно может распространяться на предпринимателей в незначительной степени).

Независимо от ограничений, режим ответственности за опасную продукцию, похоже, действительно защищает нас в сфере «повседневной жизни» с точки зрения ИИ.

Правовая ответственность за действия искусственного интеллекта: каким должен быть наш подход?

Вопрос гражданской ответственности за ИИ сильно фрагментирован. Некоторые существующие институты, похоже, готовы к новым вызовам, которые ставит искусственный интеллект. Другие требуют незначительных модификаций, а иногда и просто открытия их для ИИ. Мы также сталкиваемся с областями, которые могут подвергнуться значительной трансформации, особенно в результате законодательной деятельности.

Ускоряющееся присутствие искусственного интеллекта в окружающей нас реальности будет вызывать новые убытки, вызванные его действием или бездействием. Увеличение числа проблем с ИИ потребует юридических мер:

- на уровне его создания;

- на уровне его применения (суды могут изменять границы гражданских институтов посредством новой интерпретации нормативных актов).

Статус-кво сложен, но он обеспечивает хорошую основу для борьбы с ИИ.

Организации, рассматривающие вопрос о том, стоит ли инвестировать в решения искусственного интеллекта, не должны относиться к вопросу гражданской ответственности как к «блокирующему фактору». Напротив, в этом отношении закон достаточен для незначительных параметризаций и реконфигураций, без необходимости переписывать и изменять структуру.

Тем не менее стоит ожидать неожиданностей и быть готовым к тому, что ситуация будет развиваться в разных направлениях.

Есть определённые риски. Они могут возникнуть в результате действий законодателей и судов в отношении правонарушительной ответственности за ИИ. Они должны быть предвидены и закреплены в контрактах между поставщиками решений ИИ и их клиентами. Благодаря этим контрактам затем будут далее распространяться продукты или услуги с использованием искусственного интеллекта.

В целом, воображение, юридическая интуиция и знание ИИ – важные качества. Они необходимы юристам, занимающимся контрактами с ИИ.

Правовая ответственность за действия искусственного интеллекта будет постоянно трансформироваться. В ближайшее время в законодательстве будем ожидать множество изменений и доработок в сфере регулирования сферы искусственного интеллекта.

А что думаете Вы об этом? Оставьте своё мнение в комментариях ниже ☟.